Može da napiše pesmu u stilu bilo kog pesnika, navede progresiju akorda i vremenski potpis za jednostavnu melodiju, obezbedi recept u sedam koraka za sendvič od kikirikija, putera i želea i napiše politički vodvilj u dva čina. Pa ipak, sve što nudi odraz je nas, posredovano algoritmima koji su dobili ogromne količine materijala koje su kreirala stvarna ljudska bića.

Akronim GPT znači “generativni unapred obučeni transformator”. Koristeći sve vrste digitalizovanog sadržaja preuzetog sa interneta, GPT koristi tehnike dubokog učenja da pronađe obrasce, uključujući reči koje će se verovatno pojaviti zajedno, usvaja činjenice, upija gramatiku i uči rudimentarnu logiku

“Obučen sam za veliki skup podataka teksta, što mi omogućava da generišem ljudske odgovore na osnovu unosa koji primam”, njegove su reči.

Međutim, niti razume šta ti odgovori znače, niti uči iz iskustva, a njegova baza znanja se zaustavlja u septembru 2021. godine (pa je tako abortus i dalje ustavno pravo u SAD).

Zavodljivac pun samopouzdanja i omaški

Jedna od najuočljivijih karakteristika GPT-4 je samopouzdanje sa kojim odgovara na upite. Ovo je i karakteristika i greška. Kao što programeri GPT-4 ističu u tehničkom izveštaju koji je pratio njegovo izdanje “ponekad može napraviti jednostavne greške u rasuđivanju koje izgleda da nisu u skladu sa kompetencijom u toliko mnogo domena, ili je previše lakoveran u prihvatanju očigledno lažnih izjava korisnika i može sigurno pogrešiti u svojim predviđanjima.”

Kada je Din Buonomano, neuronaučnik sa Univerziteta u Los Anđelesu upitao GPT-4 “Koja je treća reč ove rečenice?”, odgovor je bio “treća”. Ovi primeri mogu izgledati trivijalno, ali kognitivni naučnik Geri Markus napisao je na Tviteru da “ne mogu da zamislim kako bi trebalo da postignemo etičko i bezbednosno ‘usklađivanje’ sa sistemom koji ne može da razume reč ‘treći’ čak ni sa milijardama primer.”

Prethodnik GPT-4, GPT-3, bio je obučen na 45 terabajta tekstualnih podataka, što je, prema njegovom nasledniku, ekvivalent broja reči za oko devedeset miliona romana.

Moda četbotova, mašine koje za kratko vreme daju sve odgovore

To je uključivalo unose na Vikipediji, članke iz novina i časopisa, uputstva za upotrebu, diskusije i postove sa društvenih mreža, knjige i bilo koji drugi tekst koji su njegovi programeri mogli da pribave, obično bez obaveštavanja ili kompenzacije autorima.

Nejasno je koliko je još terabajta podataka korišćeno za GPT-4, ili odakle su oni došli, jer OpenAI, uprkos svom nazivu, samo u tehničkom izveštaju kaže da je GPT-4 prethodno obučen „korišćenjem podataka sa interneta i podaci licencirani od dobavljača trećih strana“.

Ovaj izveštaj ne sadrži dalje detalje o arhitekturi, hardveru, konstrukciji skupa podataka, metodu obuke ili slično.

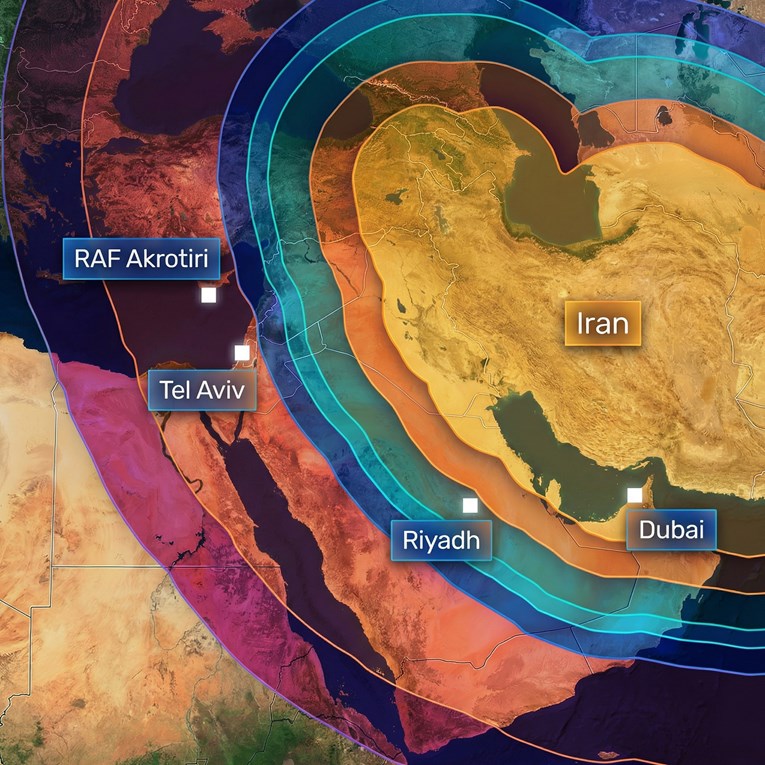

“Posebno sam zabrinut da bi ovi modeli mogli da se koriste za dezinformacije velikih razmera. Sada kada postaju sve bolji u pisanju kompjuterskog koda, mogli bi da se koriste za ofanzivne sajber napade.Postojaće i drugi ljudi koji ne postavljaju neke od bezbednosnih ograničenja koje mi postavljamo. Društvo ima ograničeno vreme da smisli kako da reaguje na to, kako da to reguliše, kako da se nosim sa tim”, rekao je nedavno za Ej-Bi-Si Njuz jedan od direktota OpenAI Sem Altman.

Ni veličina skupa podataka za obuku AI ne sprečava ga da izbacuje sadržaj mržnje. Metin A.I. četbot “Galaktika”, trebalo je da bude u stanju da “sumira akademske radove, rešava matematičke probleme, generiše članke sa Vikipedije, piše naučni kod, beleži molekule i proteine i još mnogo toga“.

Ali dva dana nakon što je demo lansiran, kompanija je bila prinuđena da ga ukloni, jer su istraživači mogli da iskoriste “Galaktiku” da kreiraju unose u Vikipediju koji promovišu antisemitizam i veličaju samoubistvo, kao i lažne naučne članke, uključujući i onaj koji se zalaže za prednosti ishrane smrvljenim staklom. Slično, GPT-3, kada je to bio zatraženo, imao je tendenciju da ponudi rasističke i seksističke komentare. Sve to zato što su mnogi podaci uneti sa diskusija i stavova iznetim na društvenim mrežama.

Kako bi izbegao ovaj problem, prema pisanju Tajma, OpenAI je angažovao kompaniju za spoljne poslove koja je angažovala izvođače u Keniji da etiketiraju podli, uvredljivi i potencijalno ilegalni materijali koji bi zatim bili uključeni u podatke o obuci kako bi kompanija mogla da napravi alat za otkrivanje toksičnih informacija pre nego što stigne do korisnika.

Tajm je izvestio da su neki od materijala “sa slikovitim detaljima opisivali situacije kao što su seksualno zlostavljanje dece, ubistvo, samoubistvo, mučenje, samopovređivanje i incest“.

Izvođači su rekli da je trebalo da pročitaju i obeleže između 150 i 250 pasusa teksta u smeni od devet sati. Bili su plaćeni ne više od dva dolara na sat i ponuđena im je grupna terapija kako bi im se pomoglo da se izbore sa psihološkim pritiskom koju je posao nosio. Autsorsing kompanija je osporila te brojke, ali je posao bio toliko uznemirujući da je ugovor raskinut osam meseci ranije.

Gutači energije, ekološki neopravdani

Prema povelji OpenAI-a, njegova misija je „da obezbedi da veštačka opšta inteligencija (AGI), pod tim podrazumevamo visoko autonomne sisteme koji nadmašuju ljude u većini ekonomski vrednih poslova, od koristi celom čovečanstvu“.

Ostavljajući po strani pitanje da li je AGI ostvariv, da li će prenošenje rada mašinama koristiti celom čovečanstvu, jasno je da AI pravi štetu čitavom čovečanstvu upravo sada. Prema članku objavljenom u jednom naučnom časopisu A.I. zahteva tone energije koja emituje ugljenik.

“Dok je ljudsko biće odgovorno za pet tona CO2 godišnje, obuka velikog neuralnog jezičkog modela košta 284 tone. Pored toga, pošto je računarska snaga potrebna za obuku najvećih modela porasla trista hiljada puta za šest godina, možemo samo očekivati da će se posledice ovih modela na životnu sredinu povećati“, stoji u člamku.

Meta, Gugl i mnoštvo manjih tehnoloških kompanija takođe su u nasumičnoj trci da izgrade sopstveni model AI. Guglov novi A.I. četbot, objavljen prošle nedelje delimično je obučen za privatne e-poruke korisnika g-mejla. Gugl je to demantovao i rekao da je u toku rani eksperiment. U međuvremenu, Majkrosoft, koji je navodno uložio deset milijardi dolara u OpenAI i koristi GPT-4 u svom pretraživaču a sada ga dodaje u vord i eksel, nedavno je otpustio ceo tim za AI-etiku. To su bili ljudi koji su bili odgovorni da osiguraju da se A.I. gradi odgovorno.

Lako je biti zaveden veštačkom inteligencijom GPT-4. Može da položi ispit, zna da kodira, uskoro će moći da pogleda fotografiju sadržaja vašeg frižidera i predloži recepte. Ali uskoro će, takođe, moći da generiše besprekorne „lažnjake“ i kreira slike od teksta uključujući i one seksualnog zlostavljanja dece. To je moćna, seizmička tehnologija koja ima kapacitet da poboljša naše živote ali i da ih umanji. Bez zaštitnih ograda i nadzora, njegove štete su predodređene da se umnože.